Напишите о независимых ошибках

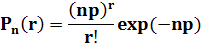

Для характеристики независимых ошибок часто используется пуассоновская модель (p << 1). Вероятность r-кратных ошибок

Пример. Если для дискретного канала связи h =  , то вероятность искажения кодовой комбинации из пяти символов

, то вероятность искажения кодовой комбинации из пяти символов

Вероятность ошибки  ; вероятность правильного приёма

; вероятность правильного приёма  . В результате получаем

. В результате получаем

41. Приведите требования к определению количества информации

Информация вводится как степень уменьшения неопределённости знаний о состоянии некоторой системы в результате проведения некоторого опыта (эксперимента).

Если до опыта неопределённость в знаниях об измеряемой величине X равна  (х), а в результате опыта неопределённость уменьшается и становится

(х), а в результате опыта неопределённость уменьшается и становится  , то получаемая в результате опыта информация

, то получаемая в результате опыта информация

Очевидно, что максимум информации будет тогда, когда  . Чем больше начальная неопределённость, тем большее количество информации получим

. Чем больше начальная неопределённость, тем большее количество информации получим

Рис.Распределение вероятностей наблюдаемой величины

Количество получаемой информации зависит от вероятности наступившего исхода.

Частная информация

Частная информация является случайной величиной, поэтому используют мат. Oжидание

| | 42.Приведите свойства энтропии

1. Энтропия является величиной вещественной и неотрицательной, т.к. значения вероятностей pn находятся в интервале 0-1, значения log pn всегда отрицательны, а значения -pn log pn в (1.4.2) соответственно положительны.

2. Энтропия - величина ограниченная, т.к. при pn 0 значение -pn log pn также стремится к нулю, а при 0 < pn 1 ограниченность суммы всех слагаемых очевидна.

3. Энтропия равна 0, если вероятность одного из состояний источника информации равна 1, и тем самым состояние источника полностью определено (вероятности остальных состояний источника равны нулю, т.к. сумма вероятностей должна быть равна 1).

4. Энтропия максимальна при равной вероятности всех состояний источника информации:

Hmax(U) = -  (1/N) log(1/N) = log N.

5. Энтропия источника с двумя состояниями u1 и u2 при изменении соотношения их вероятностей p(u1)=p и p(u2)=1-p определяется выражением: (1/N) log(1/N) = log N.

5. Энтропия источника с двумя состояниями u1 и u2 при изменении соотношения их вероятностей p(u1)=p и p(u2)=1-p определяется выражением:

H(U) = -[p log p + (1-p) log(1-p)],

и изменяется от 0 до 1, достигая максимума при равенстве вероятностей. График изменения энтропии приведен на рис. 1.4.1.

6. Энтропия объединенных статистически независимых источников информации равна сумме их энтропий.

Рассмотрим это свойство на двух источниках информации u и v. При объединении источников получаем обобщенный источник информации (u,v), который описывается вероятностями p(unvm) всех возможных комбинаций состояний un источника u и vmисточника v. Энтропия объединенного источника при N возможных состояниях источника u и М возможных состояниях источника v:

H(UV) = - H(U) = -[p log p + (1-p) log(1-p)],

и изменяется от 0 до 1, достигая максимума при равенстве вероятностей. График изменения энтропии приведен на рис. 1.4.1.

6. Энтропия объединенных статистически независимых источников информации равна сумме их энтропий.

Рассмотрим это свойство на двух источниках информации u и v. При объединении источников получаем обобщенный источник информации (u,v), который описывается вероятностями p(unvm) всех возможных комбинаций состояний un источника u и vmисточника v. Энтропия объединенного источника при N возможных состояниях источника u и М возможных состояниях источника v:

H(UV) = -   p(unvm) log p(unvm),

Источники статистически независимы друг от друга, если выполняется условие:

p(unvm) = p(un) p(vm).

С использованием этого условия соответственно имеем:

H(UV) = - p(unvm) log p(unvm),

Источники статистически независимы друг от друга, если выполняется условие:

p(unvm) = p(un) p(vm).

С использованием этого условия соответственно имеем:

H(UV) = -   p(un)p(vm) log [p(un)p(vm)] =

= - p(un)p(vm) log [p(un)p(vm)] =

= -  p(un) log p(un) p(un) log p(un)  p(vm) - p(vm) -  p(vm) log p(vm) p(vm) log p(vm)  p(um).

С учетом того, что p(um).

С учетом того, что  p(un) = 1 и p(un) = 1 и  p(vm) = 1, получаем:

H(UV) = H(U) + H(V). (1.4.3)

7. Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля, полностью игнорируя содержательную сторону ансамбля. С одной стороны, это расширяет возможности использования энтропии при анализе самых различных явлений, но, с другой стороны, требует определенной дополнительной оценки возникающих ситуаций. Как это следует из рис. 1.4.1, энтропия состояний может быть неоднозначной, и если в каком-либо экономическом начинании действие u с вероятностью pu=p приводит к успеху, а действие v с вероятностью pv=1-p к банкротству, то выбор действий по оценке энтропии может оказаться и прямо противоположным, т.к. энтропия при pv=p равна энтропии при pu=p. p(vm) = 1, получаем:

H(UV) = H(U) + H(V). (1.4.3)

7. Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля, полностью игнорируя содержательную сторону ансамбля. С одной стороны, это расширяет возможности использования энтропии при анализе самых различных явлений, но, с другой стороны, требует определенной дополнительной оценки возникающих ситуаций. Как это следует из рис. 1.4.1, энтропия состояний может быть неоднозначной, и если в каком-либо экономическом начинании действие u с вероятностью pu=p приводит к успеху, а действие v с вероятностью pv=1-p к банкротству, то выбор действий по оценке энтропии может оказаться и прямо противоположным, т.к. энтропия при pv=p равна энтропии при pu=p.

|